هال ۹۰۰۰ – این ربات (با)(بی)اخلاق

گرچه ما هنوز در تربیت «آدم» بااخلاقش هم ماندهایم،لازم است ترمیناتورهای رعبآورمان را جلویمان بنشانیم و برایشان از تعالیم ملالآوری که خودمان هم به آن پایبند نیستیم بگوییم؛ هرچه نباشد این گونهی برتر خودمان است که از سوراخی در آسمان راهش را به روی زمین بازکرده و باید در حفظ آن نهایت کوشش ازجانب ابر و باد و مه و خورشید و فلک و هوشهای مصنوعی صورت گیرد.

اصولاً بایستی وجهتسمیهای در نامگذاری کدهای اخلاقی[1] تحتعنوان «کُد» وجود داشته باشد و هم –طبیعتاً- وجود دارد؛ یعنی از بخت و اقبال بد، فرمانهای اخلاقی تماماً دلبخواه و آنطور که قلب رئوف حکم کند تولید نمیشوند. گرچه همین کُدها هم بهاقتضای زمان و مکان و چهبسا از فرد به فرد دیگر متغیرند اما مادام که بر مختصات معینی از زمان و مکان و فردیت حاکم باشند، میشوند وحی منزل و دیگر روضههایی که قلب میخواند، سودی نخواهد داشت. اما درست مثل کسی که برای هفت صبح ساعت میگذارد و در خواب و بیداری بعد از درآمدن سروصدای آلارم خاموشش میکند، تابعان کدهای اخلاقی هم گاهی در نیمهراه تبعیت پشیمان شده، گوش میدهند که دلشان (بخوانید استدلال شهودیشان) چه میگوید. همین انعطافپذیری و مسامحهی ناشی از عجز در ثبات قدم اما بهنحوی متناقض آدم بیولوژیک را در مقام قضاوت بالاتر از تحلیل مبتنی بر Big Data قرار داده است.

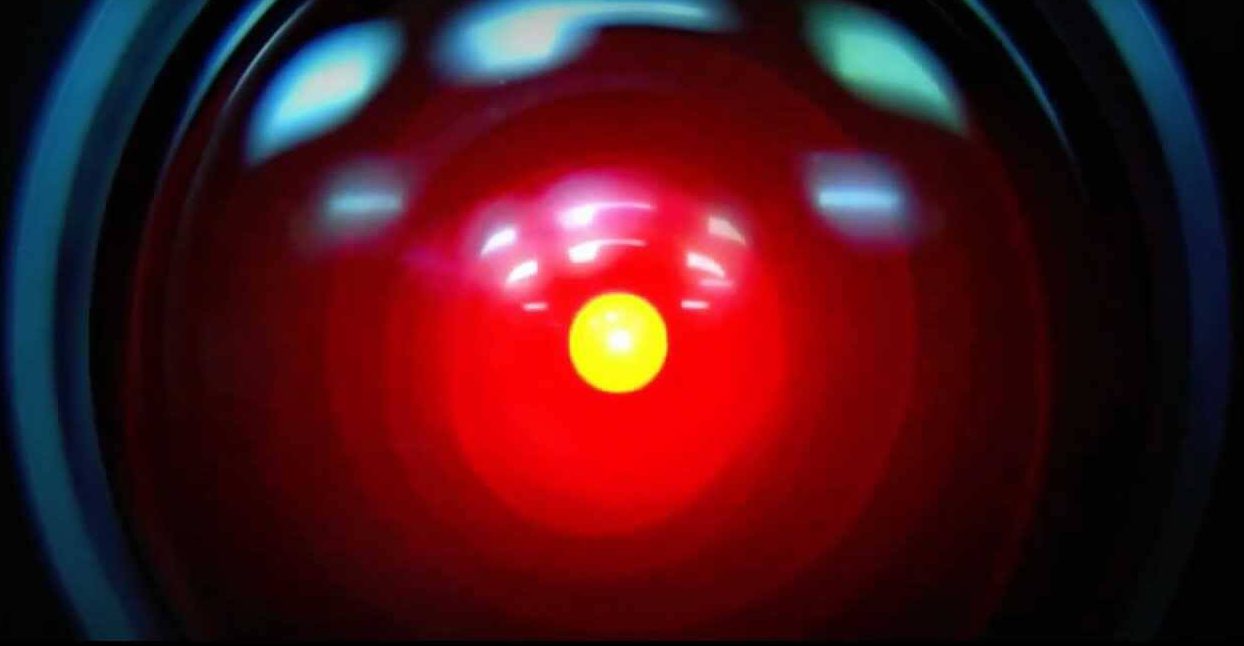

در کتاب ادیسهی فضایی 2001; A Space Odyssey آرتور سی کلارک، مغز الکترونیک سفینهی دیسکاوری وان که درعین حال – به قسم استنلی کوبریک – به بیآزاری و هم بدسگالی هر چراغ سرخ دیگری با مردمک زرد است، با یک دوراهی اخلاقی روبهرو میشود. (هال ۹۰۰۰)-HAL 9000 اینطور برنامهریزی شده که سفینه را به مقصد که در جوِ سیارهی زحل است برساند، بیآنکه ساکنین سفینه از هدف واقعی سفرشان مطلع شوند. اما وقتی اوضاع گره میخورد و هَل مجبور میشود مطابق با فرمان (Command)ی که بهش داده شده از امر و نهی فضانوردهای ازهمهجا بیخبر دیسکاوری سرپیچی کند، آدمها به جان روبات میافتند و او به جان آدمهای سفینه و تا حدی که برای چراغهای سرخ با مردمکهای زرد که عملاً اختیار تمام سفینه دستشان است امکان دارد، شروع میکند به حذف فیزیکی معاندان مأموریتش. البته طبیعتاً پیروز ماجرا همان آدمیزادی است که ما طرفش را میگیریم و همانی که بعدتر [اسپویلر] وقتی به فرزند ستارگان تبدیل میشود تشویقش میکنیم که: آفرین، خوب کردی روبات –نهچندان- زبانبسته را از موجودیت ساقط کردی تا تو را در این هیبت نبیند و دلش (بخوانید مدارهایش) خوش نباشد که وظیفهی سفر را بهخوبی به سرانجام رسانده.

اما با استناد به آنچه در مورد کُدها گفتیم، سرپیچیکردن از وظیفه، کاری بهغایت شنیعتر و زشتتر از خاموشکردن محفظههای کرایو یا بازکردن در سفینه برای بیرون انداختن اخلالگران خواهد بود. آن هم بخصوص زمانی که کسی بهمان گوشزد نکرده باشد که باید آدمها را زنده نگه داریم. البته بیست سال قبل آسیموف یکچیزهایی گفته بود، اما تجربه ثابت کرده که هیچوقت شرایط قابلاستناد به دستورالعملهای مراجع تئوریک نیست؛ یعنی در صورت برقراری هم، قانون دوم آسیموف مطرحکنندهی پایبندی به دستورات است بهشرطی که با قانون اول یعنی صدمه نزدن به انسانها منافات نداشته باشد. اما وقتی بومن و پول داشتند برای از بین بردن هال ۹۰۰۰ نقشه میکشیدند، قانون سوم (حفظ خود) در برابر قانون اول به کمک مسئولیتپذیری برای اجرای عملیات آمد و حالا دوتایی وزنهی سنگینتری به نظر میرسیدند.

باری اگر هال ۹۰۰۰ با فضانوردها همدست میشد و همگی با هم میگفتند گور بابای مأموریت، ربات بهتری بود؟ یا برای اتکاکردن به غرایز و هرچه دل آدم میگوید، باید در وهلهی اول «دلِ آدم»ی وجود داشته باشد که بخواهد چیزی بگوید؟ نمونههای رباتها و هوشمصنوعیهایی که کنترلشان از دست آدمها خارج میشود در مدیای ترسان و لرزان رتروفیوچریستها کم نیست؛ اما تقریباً هیچکدامشان از روی بدجنسی یا خباثت و سایر رذایل اخلاقی دست به آدمکشی و بدعملکردن نمیزنند. چهبسا بدویترین غریزهی انسانی که برای آنها میشود قانون سوم رباتیک، رانهی پلیدترین سوءعملهای آنها باشد.

اینجا البته باید رانهی بقا یکبار دیگر مرور شود. برای انسان عاطفی (سِنتیمنتال) غریزهی بقا یا قانون سوم آسیموف تبصرهای شاعرانه دارد که وقتی از همهجای دیگر رانده میشود و درحقیقت در تناقضات منفعت و ضرر از خودش مایه بگذارد و یک طرف صورتمسئله را با قربانیکردن خودش پاک کند. البته این عمل درعین اینکه بهظاهر برخلاف مقتضیات تکامل بهنظر میرسد، کیفیتی است که منحصر به آدمهای شریف داستانهای چارلز دیکنز نبوده و جلبکهای تکسلولی هم از این میزان شرافت برخوردارند. باری، وجه تمایزی که کاراکترهای دیکنز با جلبک دارند این است که جلبک، درحین اینکه با مرگ برنامهریزی شده (که هم میتواند بهمعنای صفت و هم اسم فرآیند آپوپتوز به کار رود) خودش را قربانی میکند، خیالش راحت است که مواد غذایی آزادشده از سلولش، تنها برای جلبکهای خویشاوندش قابلاستفاده خواهد بود. مزیت تکاملی خودکشی برای دیگران –بهمعنای تحتاللفظی آن- همینجا و در قانون همیلتون روشن میشود. ممکن است شما نتوانید نسل خودتان را نجات دهید، اما اولویت دوم در لیست، خویشاوندان درجهاول با بیشترین تشابه ژنی با شما هستند؛ به همین دلیل است که ما معمولاً برای غریبهها –و کسانی که برایمان تب نمیکنند- نمیمیریم آقای دیکنز!

حالا بعد از ضایعکردن احساس غرور و افتخار فداکاری با توجیه نکبتباری چون ژنتیک و دیانای و سلولهای پلید گامت، باید اعتراف کرد که توجیهی فلسفی اتفاقاً برای فداکاری و شهادت در راه کشور و دین و عقیده –و شاید غریبهها- هم وجود دارد. در یک نگاه کلیتر، به دلایلی که برای نگارندهی جامعهگریز پوشیده است، هموطنان و افرادی که عقیدهشان با شما مشترک است را میتوان اعضای خانوادهای بزرگتر قلمداد کرد و با تلقین روانشناسانهی «خواهر و برادر»بودن با همهشان، این هزینهی گزاف را به نفع آنان پرداخت. هرچند به هر حال آنقدری هم از عمر گونهی ما نگذشته که تفاوت چشمگیر ژنی دست و پایمان را در این اغماض ببندد. البته اینجا بحث هزینه/سودمندی[2] هم مطرح است و هرچه جمعیتی که از فداکاری ما منتفع میشوند بزرگتر باشد، درصد رضا دادن به غریبگیشان بالاتر است.

با این حال تمام این توجیهات بیولوژیک و روانشناسانه در مورد هوش مصنوعی اعتبار خود را از دست میدهد. طبیعتاً روباتها خواهر و برادر و پدر و مادر و دایی و عمه و هموطن و همزبان ندارند و بقا تنها برای قطعات مکانیکی خودشان – آن هم در برههای که دیگر به شکل آهنپاره نیست- قابل تعریف است. «آگاهی» که هال ۹۰۰۰ آنقدر از ازدستدادنش میترسد و بابتش به بومن التماس میکند، تنها پیوند او با موجودیت است. این همان پیوند مشابهی است که آدم هم در مواجهه با مرگ وقتی حواسش نیست تا خودش را با «عوضش پسرخالهی مامانت زنده میمونه» دلداری بدهد محکم به آن چنگ زده و حاضر نیست در ازای هیچ توجیه تکاملی و دراماتیکی آن را از دست بدهد.

اما اگر آدمی بهخاطر زندهماندن خودش دست به قتل بزند هم، بیشتر از اینکه شبها از عذابوجدان صورت مقتول به مقدار متنابهی توی تختخواب غلت بخورد از او انتظار نداریم. با وجود اینکه باب کنارهگیری از زندگی بهنفع دیگران همیشه باز است و اتفاقاً -بهاشتباه- مورد تشویق هم قرار میگیرد، اگر کسی حرفش را پیش نکشد، دِینی بر گردن هر بختبرگشتهای که نمیداند چه خاکی به سرش بریزد، نیست. باری، قانون جنگل از این سو هم اعمال میشود و همان اندازه که پلنگ را برای کشتن گورخر ملامت نمیکنند –چون در غیراینصورت نسل پلنگها را منقرض کرده است؛ حتی اگر خیال کند که دارد بقای دیگر پلنگان را موجب میشود-، کسی هم به قاتل شریفی که چارهی دیگری نداشته نمیگوید: چرا چاره داشتی! خوبشم داشتی! بگو ببینم چرا خودت رو نکشتی؟

اما ماشینها و بدنهای فلزی که بهطور پیشفرض در سلسلهمراتب حیات باید پایینتر از ما قرار بگیرند، در چنین موقعیتهای مرگ و زندگی، سر از سمت شر نبرد برای بقا درمیآورند. البته روبوفوبیا بیشتر از آنکه بتواند اسم «فوبیا» بگیرد قابلدرک است. هوشی فراتر از هوش ما، قدرتی غالب، عاری از موانع تعلق و احساسات و البته بسیار سفتتر از بدنهای زهواردررفتهی انسانی؛ تنها یکیشان برای مرعوب کردن قلهی زنجیرهی غذایی کافی است. بهعلاوه اعطای امتیاز انسانی برخورداری از حواس محیطی زمان حاضر –و نه خاطرهی آن حواس- تنها با شباهت هرچه بیشتر هوشمصنوعی با آدمیزاد تا بهحدی که از پوست و گیرندههای حسی واقعی برخوردار شوند، معناپذیر است و شاید تازه آن موقع که نشود آدم را از غیرآدم (منظور روبات است) تمیز داد، قوانین تازهای را طلب بکند.

بیشتر بخوانید: پروندهی هوش مصنوعی – امیدها و ترسها

با وجود تمام آنچه گفته شد، قضاوت برمبنای شواهد و برنامهریزی و در پیشرفتهترین حالت برمبنای بیگدیتای به دست آمده از تجربیات انسانی، همچنان از یک عنصر زیستی بهغایت حیاتی محروم است. بالفرض که هوش مصنوعی ما قادر به پایبندی به هر سه قانون آسیموف بود، آیا تمام اخلاقیات را میشود در سه سطر خلاصه کرد و یا آنقدر موقعیتهای منحصر به فرد و متفاوت از هر موقعیت دیگری پیش نخواهد آمد که کار با یک «قرص» تجربه ختم به خیر نشود؟ کیفیت انسانی، یک آمادگی مشابه همان آمادگی برای فداکاری است؛ نه فقط منحصر به آن، اما نه چندان هم نامربوط؛ امکان تغییر اولویتها و اساساً اولویتگذاری در عمل که مبنای برنامهی زیستی و برای هر آدمی ویژهی خود اوست. این تصور که هزار هال ۹۰۰۰ دیگر میتوانند همگی یک عقیده و یک هدف واحد داشته باشند و هرگز تزلزلی در اگر (If) و آنموقع (then)های الگوریتمشان صورت نگیرد، در ذات به ترسناکی هر کیفیت ماشینی دیگری است که از آن برخوردارند. حال آن که اگر تنها بین روباتها اختلاف نظر پیش میآمد و یکی میگفت بومن را تکهتکه کنیم (قانون دوم و سوم)، یکی دیگر میگفت نه گناه دارد (قانون اول)، آسودگی نشأتگرفته از این بینظمی چهبسا میتوانست روباتهای متخاصم را هم در مقیاس بزرگ جمعی ببخشاید.

یک راه مواجهه با این محدودیت، کنارگذاشتن آنها و اجتناب از پیشرفتهای تکنولوژی و درپیگرفتن مرام غارنشینی است. به هرحال باید بپذیریم که درصد خطای ماشینها در اتخاذ تصمیم در موقعیتهای خطیر مرگ و زندگی اگر تئوری توطئهی غرب –و نه شرق که با آغوش باز پذیرای هر Drone و هوش مصنوعی است که در خانهشان را بزند- مبنیبر تبانی کامپیوترها علیه انسانها رد بشود، بسیار پایینتر از خطای عقل و هوشمندیایست که آدمیزاد آنقدر به آن مینازد. روباتهای سرباز وحشیگری و غارت و تجاوز بلد نیستند و بنا به تخمین سباستین ثرون[3] اتومبیلهای بدون راننده سالانه جان یک میلیون نفر را نجات میدهند.

بنابراین بهتر است بهجای پاککردن صورت مسئله، دنبال تعمیم قانونهای آسیموف باشیم تا خیالمان راحت باشد که دستکم محکمهی مشترکی که انسان را برای اعمالش بازخواست میکند، دنبال ادله و دفاعیات یکسانی در نیات (بخوانید کدها)ی روباتها خواهد بود. نخست، باید مشخص شود که درصورت بد-عمل-کردن روبات، تقصیر را باید گردن چه کسی بیندازیم؟ طراح، برنامهنویس و سازنده و یا اپراتور همه در مظن اتهام قرار دارند و راه محکومکردن یکی از آنها گرفتن گزارش از دلیل و منطق پشت هر عمل و تصمیمی است. خوبیاش هم این است که ممکن است انسان خودش را به کوچهی علیچپ بزند، اما هوشمصنوعی قاتل اگر بخواهد شما را به قتل برساند، صادقانه خواستهی قلبیاش را اعلام میکند. البته اینجا باید تمایزی بین قوانین ازپیشتعیینشده و استفاده از شبکههای عصبی مصنوعی یا Big Data قائل شد. ممکن است ربات شما با منطقی اشتباه (با این حال همچنان تحت عنوان منطق) بتواند اعمالش را توجیه کند؛ در آنصورت چندان هم نمیشود به او خرده گرفت؛ دستکم نه بیشتر از آدمی که مشاعرش را از دست داده.

در مرحلهی بعد بایستی از ثبات مفهوم «درست» و «غلط» اطمینان حاصل کنیم و چه شاهدی بهتر از آمار و ارقام اکثریت –طبیعتاً- حقبهجانب و اقلیت جنایتکار؟ به عبارت دیگر، اگر انجام کاری مورد پذیرش عموم باشد، روباتمان هم اجازهی ناخنکزدن به آن را پیدا میکند و برعکس. باری، فلسفهی عملی انسانی در برابر دوراهیهای اخلاقی تعیینکنندهی جریان آب خواهد بود. درنهایت، برخلاف تصور «آشپز که دو تا شد، آش یا شور میشود یا بینمک»، تعامل پیوستهای بین مهندسین و متخصصین حوزهی اخلاق، قانونگذاران و وکلا لازم است تا هرکدام توصیهی مربوط به حوزهی خودشان را به مجموعهی سوگندنامهی صفرو یکی روباتمان اضافه کنند.

به هر ترتیب، گرچه ما هنوز در تربیت «آدم» بااخلاقش هم ماندهایم، اما برای اینکه از پیشبینیهای یک دوجین کتاب و فیلم رتروفیوچریست عقب نمانیم و بیشتر به آن دلیل که از هر بحران نابودی کرهی زمین به دست روباتها و سایبرمنها بهسلامت به بحران بعدی در رسانهی دیگری گذر کنیم، لازم است ترمیناتورهای رعبآورمان را جلویمان بنشانیم و برایشان از تعالیم ملالآوری که خودمان هم به آن پایبند نیستیم بگوییم؛ هرچه نباشد این گونهی برتر خودمان است که از سوراخی در آسمان راهش را به روی زمین بازکرده و باید در حفظ آن نهایت کوشش ازجانب ابر و باد و مه و خورشید و فلک و هوشهای مصنوعی صورت گیرد.

پانویسها

[1] Moral Codes

[2] Cost-Benefit

[3] Sebastian Thrune